„Social Loafing“ heißt das Phänomen, wenn Menschen in einem Arbeitsteam ihre Anstrengung reduzieren und sich auf den Beitrag anderer Teammitglieder verlassen. Dieser sozialpsychologische Effekt ist in menschlichen Teams bereits gut dokumentiert.

Dass dies auch in einem gemischten Mensch-Roboter-Team passieren kann, legt nun eine Studie von Forscherinnen der TU Berlin mit 42 Teilnehmenden nahe. In der Studie fanden Menschen, die im Team mit einem Roboter eine doppelte Qualitätsprüfung vollzogen, weniger Fehler als eine Vergleichsgruppe, die alleine arbeitete.

Schon heute kooperieren viele Menschen mit Künstlicher Intelligenz (KI) und Robotern – besonders in großen Produktionsbetrieben. In mehreren Studien wurde bereits festgestellt, dass Menschen ein technisches System sehr leicht als Teampartner wahrnehmen können. Sie neigen dazu, soziale Regeln, Erwartungen und Verhaltensmuster aus der menschlichen Interaktion auch dann anzuwenden, wenn sie Technik nutzen.

„Bei der Zusammenarbeit mit Robotern könnte diese Tendenz noch stärker ausgeprägt sein. Da lag es nahe, zu überprüfen, ob auch typische gruppenpsychologische Phänomene wie das Social Loafing in Mensch-Roboter-Teams auftreten können“, sagt Prof. Dr. Linda Onnasch, Leiterin des Fachgebiets Handlungs- und Automationspsychologie an der TU Berlin.

Roboter und Mensch: Parallele Fehlersuche auf Leiterplatten zeigt Social Loafing

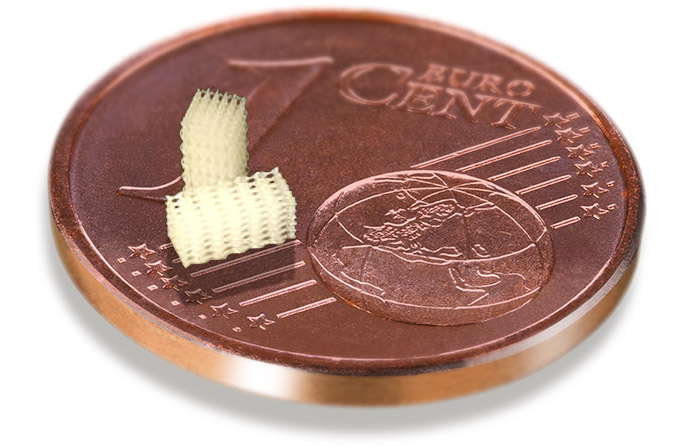

Um das herauszufinden, teilten die Autorinnen der Studie 42 Studierende in zwei Gruppen ein. Beide mussten elektronische Bauteile auf Leiterplatten auf Qualitätsmängel inspizieren. Die Leiterplatten waren dabei auf einem Bildschirm als Ganzes nur verschwommen zu sehen – erst wenn die Versuchsperson mit der Maus über bestimmte Bereiche fuhr, waren diese scharf zu erkennen. Damit war es den Forscherinnen möglich, das Vorgehen der Teilnehmenden im Detail zu verfolgen.

Während die eine Gruppe die Fehlersuche allein bewältigen musste, bekam die andere Unterstützung von einem Roboter, der den Teilnehmenden mit dem Namen „Panda“ vorgestellt wurde. Er fotografierte und untersuchte die Leiterplatten mit hörbaren Geräuschen hinter einer Trennwand. Dann erschienen die Bildaufnahmen inklusive der von Panda gesetzten Fehlermarkierungen auf dem Bildschirm der Probanden.

Panda fand fast alle Fehler. Nur im letzten Viertel des Versuches wurden fünf Fehler von Panda nicht detektiert. Beide Gruppen haben die Forscher nach dem Experiment gefragt, wie sie ihr eigenes Engagement bei der Arbeit einschätzen, wie verantwortlich sie sich für die Aufgabe gefühlt und wie gut sie ihrer Meinung nach gearbeitet hatten. Außerdem ermittelten die Forscherinnen, wie viele Fehler, die von Panda nicht detektiert wurden, die Teilnehmenden fanden und wie häufig dies in der Vergleichsgruppe der Fall war.

Im Roboter-Team gaben sich Menschen unbewusst weniger Mühe

Auf den ersten Blick sah es so aus, als ob die Anwesenheit von Panda keinen Unterschied gemacht hätte: Es gab keinen statistisch signifikanten Unterschied zwischen den Gruppen in Bezug auf die Zeit, die für die Inspektion der Leiterplatten aufgewendet wurde. Die prozentual inspizierte Fläche der Leiterplatten lag in beiden Gruppen bei rund 90 Prozent. Die Teilnehmenden beider Gruppen bewerteten auch ihr Verantwortungsgefühl für die Aufgabe, die aufgewendete Mühe und die Leistung ähnlich hoch.

Als die Forscherinnen jedoch die Fehlerquoten genauer untersuchten, stellten sie fest: Die Versuchspersonen, die mit Panda arbeiteten und bereits gesehen hatten, dass Panda viele Fehler erfolgreich markiert hatte, entdeckten die später auftretenden, verpassten Fehler seltener als die Vergleichsgruppe. Sie leisteten also merklich schlechtere Arbeit.

„Obwohl die Teilnehmenden dachten, sie würden gleich viel Aufmerksamkeit aufbringen, gingen sie unbewusst offenbar davon aus, dass Panda keine Fehler übersehen hatte und nahmen ihre mentale Anstrengung bei der Suche zurück“, vermutet Helene Cymek, die Erstautorin der Studie.

Zentrum für Bionic Intelligence Tübingen Stuttgart gegründet

Menschen verlassen sich auf die Maschinen – das führt zum Social Loafing

Dass dieser Effekt bereits nach einer Versuchsdauer von nur 90 Minuten auftritt, sei besorgniserregend, erklärt Linda Onnasch. „In längeren Arbeitsschichten, bei denen viel Routineaufgaben erledigt werden müssen und wo es kein sofortiges Feedback zur eigenen Arbeitsqualität gibt, müssen wir davon ausgehen, dass solche Effekte in Mensch-Roboter-Teams noch stärker ausgeprägt sind.“

Für Produktionsbetriebe und alle Arbeitssituationen, wo aus Sicherheitsgründen doppelte Kontrollen durch Maschinen und Menschen stattfinden, sei das keine gute Nachricht.

www.tu.berlin/hap/ueber-uns/leitung

Kontakt zu den Forschern:

Prof. Dr. Linda Onnasch

Fachgebiet Handlungs- und Automationspsychologie

Institut für Psychologie und Arbeitswissenschaft

Technische Universität Berlin

E-Mail: linda.onnasch@tu-berlin.de