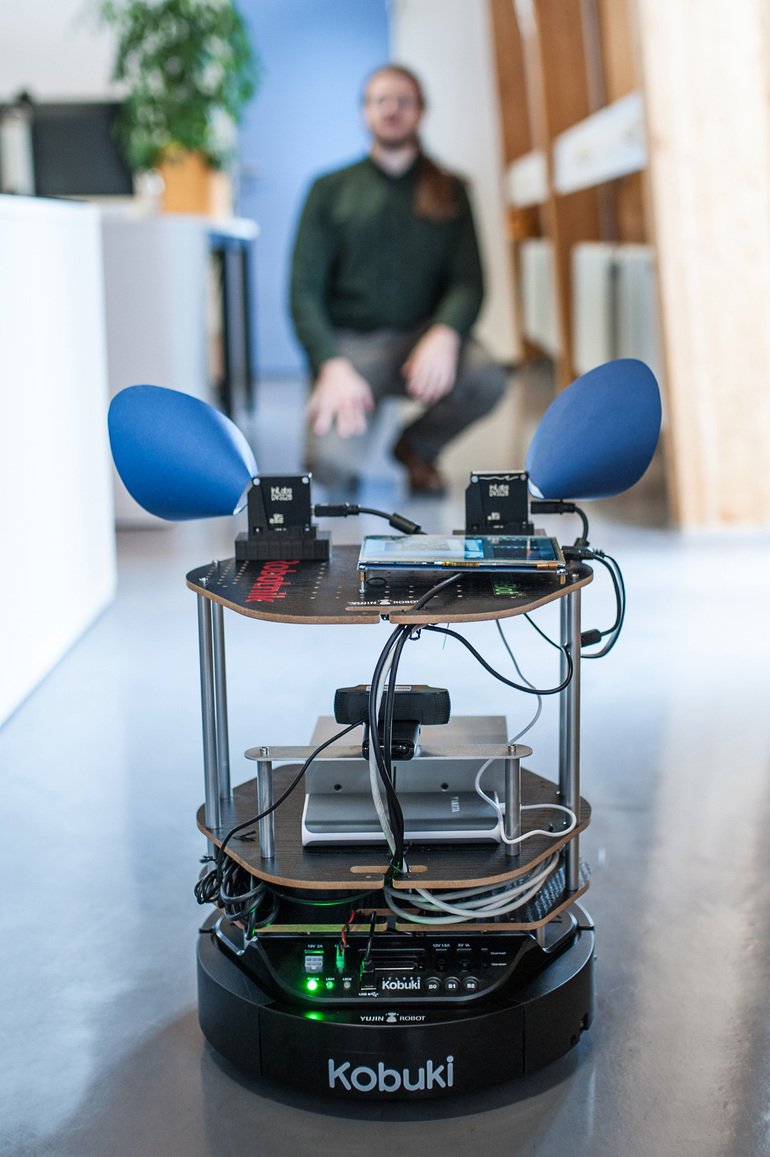

Er hat tintenblaue Ohren, und mit seinen dunklen Kameraaugen, die seitlich auf dem rundlichen Aufbau montiert sind, sieht er recht possierlich aus. Auf einem fahrbaren Untersatz rollt der kleine Roboter den Ulmer Wissenschaftlern vorsichtig entgegen. Der Ninja Turtle, so sein Name, hilft den Neuroinformatikern und Kognitionsforschern der Universität Ulm dabei, spezielle Algorithmen zu testen, die der menschlichen Wahrnehmung und Kognition nachempfunden sind. Damit wollen die Ulmer Forscher die Verarbeitung von visuellen und auditiven Sensordaten robuster, schneller und effizienter machen. Das Projekt ist Teil des „Neurorobotik“-Programms der Baden-Württemberg-Stiftung und wird mit 500 000 Euro unterstützt.

Gehirn verarbeitet Daten am effektivsten

„Das menschliche Gehirn gehört noch immer zu den effektivsten Datenverarbeitungssystemen überhaupt“, erklärt Prof. Heiko Neumann, stellvertretender Leiter des Instituts für Neuroinformatik. „Vor allem bei der Auswertung von Sinneseindrücken arbeiten natürliche Nervensysteme hocheffektiv und sind vielen technischen Systemen überlegen.“

Im Mittelpunkt des Projekts steht die Entwicklung so genannter neuro-morpher Algorithmen, die sich in ihrer Struktur und Arbeitsweise am menschlichen Gehirn und seinen elementaren Bestandteilen, den Neuronen, orientieren. Ausgangspunkt ist dabei die Frage, wie visuelle und auditive Sensorströme verarbeitet, fusioniert und technisch genutzt werden können, beispielsweise für die räumliche Orientierung und Navigation.

Nur relevante Daten werden ausgewählt

„Die menschliche Wahrnehmung ist nicht wie bei technischen Systemen getaktet, sondern arbeitet ereignisbasiert“, erklärt Prof. Marc Ernst, Leiter der Abteilung für Angewandte Kognitionspsychologie der Uni Ulm. Das heißt, relevant ist vor allem das, was sich über einen bestimmten Zeitraum hinweg verändert. „Aus all den Informationen, die auf uns einströmen, wählt das Gehirn nur diejenigen aus, die ‚überlebensrelevant‘ sind und in der jeweiligen Situation einen Sinn ergeben.“ Das Gehirn kombiniere sensorische Signale mit Erwartungen aus unterschiedlichen Erfahrungskontexten und verrechnet die Informationen zu einem multisensorischen Gesamteindruck. „Die Integration dieser sensorischen Datenströme ist eine Meisterleistung des Gehirns. Wenn wir verstanden haben, wie das genau funktioniert, können wir versuchen, diese Funktionsweisen auf technische Systeme zur Sensordatenverarbeitung zu übertragen“, fassen die Ulmer Forscher ihren wissenschaftlichen Auftrag zusammen.

Um die neuro-morphen Algorithmen zu generieren, haben die Ulmer Wissenschaftler biologisch plausible Lernverfahren entwickelt, mit deren Hilfe die „relevanten“ Informationen aus der Gesamtheit der sensorischen Daten herausgefiltert werden können. Jetzt wollen die Forscher herausfinden, wie praxistauglich und leistungsfähig die Algorithmen sind. Dafür werden sie auf der Roboterplattform implementiert und zunächst an einfachen Orientierungsaufgaben getestet. Diese Aufgabe übernimmt der Roboter Ninja Turtle.

Rechner mit vom Gehirn inspirierter Hardware

Um die Algorithmen zu realisieren, kommt in ihm eine so genannte gehirninspirierte Hardware zum Einsatz, bei der Prozessor und Speicher nicht getrennt sind, wie dies bei herkömmlichen Rechnern der Fall ist. Vielmehr arbeiten sie vereint wie Neuronen und ihre synaptischen Verbindungen im Gehirn. Damit lassen sich die Daten wesentlich schneller und effizienter verarbeiten.

Wenn alles gut geht, wird sich der kleine Roboter Ninja Turtle unbehelligt von Störgeräuschen auch bei schwierigen Sichtverhältnissen seinen Weg zielstrebig durch das Labor bahnen, und dabei nur einen Bruchteil der Rechenkapazitäten und des Speicherplatzes brauchen, der für herkömmliche Rechnerarchitekturen erforderlich ist.

www.bwstiftung.de/neurorobotik/