Eine Banane lässt sich umgreifen, ein Knopf sich drücken. Selbst Kleinkinder kommen schnell hinter die Prinzipien, was man mit der Hand alles machen kann. Greifsysteme für Roboter brauchten bisher konkrete Angaben, um in verschiedenen Fällen das Richtige zu tun.

Ein neues Greifsystem, das Bielefelder Wissenschaftler entwickelt haben, funktioniert jedoch, auch ohne dass es vorher die Merkmale von Objekten wie Obst oder Werkzeug kennt. Entwickelt wurde das Greif-Lern-System im Großprojekt „Famula“ des Exzellenzclusters Kognitive Interaktionstechnologie (Citec) der Universität Bielefeld – rund 1 Mio. Euro wurden dafür aufgewendet.

Eine Roboterhand für den Einsatz im Haus

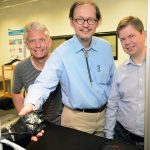

Das Wissen, das die Fachleute im Projekt zusammengetragen haben, könnte zum Beispiel dazu beitragen, dass künftige Serviceroboter sich in neue Haushalte einarbeiten. „Unser System lernt durch Probieren und eigenes Erkunden – so wie auch Babys sich neuen Objekten widmen“, sagt Prof. Helge Ritter. Der Neuroinformatiker leitet das Projekt zusammen mit dem Sportwissenschaftler und Kognitionspsychologen Prof. Dr. Thomas Schack und dem Robotiker PD Dr. Sven Wachsmuth.

Die Citec-Wissenschaftler arbeiten mit einem Roboter mit zwei Händen, die den menschlichen in Form und Beweglichkeit nachempfunden sind. Die „Fingerkuppen“ sind mit winzigen Sensoren ausgestattet. Das zugehörige Robotergehirn muss lernen, wie alltägliche Objekte, etwa Obst, Geschirr oder auch Plüschtiere, durch ihre Farben und Formen unterschieden werden können, und worauf es ankommt, wenn es sie greifen will.

Menschen machten vor, worauf die Roboterhand achten muss

„Das System lernt, solche Möglichkeiten aus Merkmalen zu erkennen und baut sich ein Modell für den Umgang und die Wiedererkennung auf“, sagt Ritter. Dafür verbindet das interdisziplinäre Projekt Arbeiten der künstlichen Intelligenz mit Forschungsarbeiten weiterer Disziplinen. So untersuchte die Gruppe von Thomas Schack, welche Merkmale Versuchspersonen als bedeutsam bei Greifaktionen wahrnehmen. In einer Studie mussten Probanden die Ähnlichkeit von mehr als 100 Objekten vergleichen. „Überraschend war, dass das Gewicht kaum eine Rolle spielt. Wir Menschen verlassen uns vor allem auf die Form und die Größe, wenn wir Dinge unterscheiden“, sagt Schack.

In einer weiteren Studie ließen sich Testpersonen die Augen verbinden und hantierten mit Würfeln, die sich in Gewicht, Form und Größe unterschieden. Infrarotkameras zeichneten die Handbewegungen auf. „Dadurch erfahren wir, wie Menschen einen Gegenstand ertasten und welche Strategien sie bevorzugt nutzen, um seine Eigenschaften zu erfassen“, sagt Dr. Dirk Koester, Mitarbeiter in Schacks Gruppe. „Wir erfahren natürlich auch, welche Fehler Menschen beim blinden Ertasten machen.“

Lern-Mentor zeigt dem Roboter, was als nächstes probiert wird

Dr. Robert Haschke aus der Gruppe um Helge Ritter nimmt im Experiment mit dem Roboter die Rolle eines menschlichen Lern-Mentors ein. So teilt er den Händen mit, welches Objekt auf dem Tisch sie als nächstes inspizieren sollen. Dazu zeigt Haschke auf Gegenstände oder gibt sprachliche Hinweise, wie etwa eine Richtung („hinten links“). Zwei Monitore zeigen, wie das System über Farbkameras und Tiefensensoren seine Umgebung wahrnimmt und auf die Kommandos des Menschen reagiert.

„Die Hände müssen Sprache, aber auch Gestik deuten können, um zu verstehen, mit welchem Objekt sie sich befassen sollen“, erklärt Dr. Sven Wachsmuth vom Citec-Zentrallabor. „Und sie müssen sich in die Position des Menschen versetzen können, auch um nachzufragen, ob sie richtig verstanden haben.“

Wachsmuth und sein Team sind nicht nur für die Sprachkompetenz des Systems zuständig. Sie haben ihm auch ein Gesicht gegeben: Von einem der Bildschirme aus verfolgt der stilisierte Roboterkopf Flobi die Bewegung der Hände und reagiert auf Anweisungen. Der Roboterkopf soll die Sprache und die Handlungen des Roboters durch Gesichtsausdrücke ergänzen. Als Teil des Famula-Systems ist derzeit die virtuelle Version des Roboters im Einsatz.

Erkenntnisse für noch komplexere Roboterhand mit mehr Fingern nutzen

Mit Famula betreiben die Citec-Forscher Grundlagenforschung, die künftigen selbstlernenden Robotern in Haushalt und Industrie zugutekommen kann. Das langfristige Ziel: Erkenntnisse zu gewinnen für den künftigen Einsatz komplexer, vielfingriger Roboterhände, die heute noch zu kostspielig und zu komplex für den Einsatz zum Beispiel in der Industrie sind.

Weitere Informationen

Der Projektname Famula steht für Deep Familarization and Learning Grounded in Cooperative

Manual Action and Language: from Analysis to

Implementation. Das Projekt läuft seit 2014 und

ist zunächst bis Oktober 2017 befristet.