Roboter lassen sich mithilfe menschlicher Gehirnaktivität über sogenannte Brain-Computer-Interfaces (BCIs) steuern. Dabei kommt Elektroenzephalografie (EEG) zum Einsatz, bei der am Kopf angelegte Elektroden Potentialänderungen im Gehirn messen. Wissenschaftler des Robotics Innovation Center am Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) und der Arbeitsgruppe Robotik der Universität Bremen entwickeln hier nun einen ganzheitlichen neuen Ansatz, der weiter geht als klassische BCIs: Mit „embedded Brain Reading“ (eBR) kann die Gehirnaktivität nicht nur gemessen, sondern auch interpretiert werden. Auf diese Weise lassen sich Handlungsabsichten und die kognitive Auslastung von Personen erkennen.

Integration der Gehirnaktivität in die Steuerung

Dabei setzt eBR ausschließlich auf die passive Beobachtung natürlich auftretender Gehirnaktivität und vermeidet so eine Mehrbelastung des Menschen durch die Nutzung eines BCIs. Zusätzlich zum EEG werden die Elektromyografie zur Messung der Muskelaktivität, Eye-Tracking und die Bewegungsanalyse eingesetzt. Der innovative Ansatz ermöglicht die vollständige und fehlertolerante Integration der Gehirnaktivität in die Steuerung technischer Systeme. Dies machen sich die Forscher zum Beispiel bei der Teleoperation von Weltraumrobotern, aber auch bei der EEG-basierten Steuerung robotischer Exoskelette zunutze.

Roboter lernen aus eigenem Fehlverhalten

Beim embedded Brain Reading dienen ereigniskorrelierte Potentiale (engl.: event related potentials, ERPs) im EEG als Input-Quellen, die als Reaktion auf eine interne Zustandsänderung oder einen externen Reiz entstehen. Am DFKI werden diese Potentiale genutzt, um die Interaktion zwischen Mensch und Roboter zu verbessern. So entwickelten sie zum Beispiel ein Verfahren des Maschinellen Lernens, bei dem ein Roboter aus dem eigenen Fehlverhalten in der gestengesteuerten Interaktion mit dem Menschen lernen kann. Der Roboter ist dabei in der Lage, gleichzeitig zu lernen, die Gesten des Menschen zu unterscheiden und den von ihm ausführbaren Aktionen zuzuordnen. Ob diese Zuordnung richtig oder falsch war, erfährt er anhand der EEG-Messung beim Menschen, durch die er im Falle einer fehlerhaften Aktion ein negatives Feedback, ein so genanntes fehlerkorrelierte Potential, erhält.

Unterbewusstes Feedback entlastet den Mensch

Dies entlastet den Menschen in der Interaktion, da er die Rückmeldung nicht bewusst an den Roboter geben muss, sondern diese dank eBR bereits auf der unterbewussten Ebene bei ihm abgegriffen wird. Die Bremer Forscher konnten das auf intrinsisches Feedback beruhende Verfahren erstmals in der Interaktion mit einem echten Robotersystem anwenden, und zeigen, dass es zu einer Verbesserung der Interaktion zwischen Mensch und Roboter führt.

Verarbeitung physiologischer Daten in Echtzeit

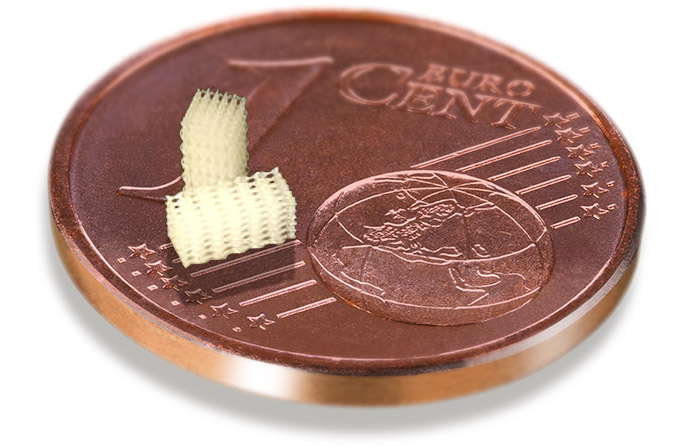

Damit das Robotersystem in Echtzeit reagieren kann, um eine möglichst natürliche Unterstützung der Bewegungen zu realisieren, müssen die anfallenden riesigen Datenmengen schnell verarbeitet werden. Die Forscher entwickelten daher ein kompaktes Brain-Reading-System zur Echtzeit-Bewegungsvorhersage, das die Datenmenge innerhalb weniger Nanosekunden bewältigt – und ein Exoskelett so genau im richtigen Moment die Armbewegung unterstützen kann.

www.dfki.de/robotik/de/forschung/projekte/recupera-reha.html

www.dfki.de/robotik/de/forschung/softwaretools/respace.html

www.frontiersin.org/articles/10.3389/fnins.2018.00188/full

www.nature.com/articles/s41598–017–17682–7

www.mdpi.com/1424–8220/17/7/1552/htm