Herr Dr. Kellmeyer, wenn man mit Fachleuten über Brain Computer Interfaces spricht, entsteht meist der Eindruck: Es geht um ein spannendes Feld, aber die Möglichkeiten sind noch begrenzt. Wie gut kommt künstliche Intelligenz heute schon an Daten aus einem Gehirn heran?

Das kommt auf die Methode an. Bisher haben wir vor allem das EEG, mit dem häufige und lange Messungen möglich sind. Hier lässt jedoch die räumliche Auflösung zu wünschen übrig. Im MRT ist sie sehr gut – aber damit können wir nur zeitlich begrenzt messen. Spezielle, invasive Methoden wie das Messen mit Nadelelektroden, die in das Gehirn eindringen, sind nur in besonderen Fällen anwendbar. Es ist aber zu erwarten, dass neue Methoden entstehen, mit denen wir sowohl zeitlich als auch räumlich detaillierte Daten bekommen und dann ein viel genaueres Bild der Hirnaktivität erhalten können.

Was war der Anlass für die aktuelle Veröffentlichung zum Hirndatenschutz?

Es gibt sowohl in den USA als auch in Europa große Programme, in denen es um die Erforschung des menschlichen Hirns geht. In Europa ist das Ziel das Erstellen eines Modells, in Amerika sind die Arbeiten darauf ausgerichtet, zu nutzbaren Werkzeugen zu kommen. Die beteiligten US-Forscher haben im Mai 2017 einen Workshop organisiert, bei dem Mediziner, Ingenieure, Rechtsexperten und Ethiker über die heutige Situation und die absehbaren Entwicklungen intensiv diskutiert haben. Die Veröffentlichung fasst einige Diskussionspunkte dieses Workshops zusammen. Einigkeit bestand aber in dem Punkt, dass wir alle Handlungsbedarf sehen, was den Schutz von Hirndaten angeht.

Welche Entwicklungen machen diesen Schutz erforderlich?

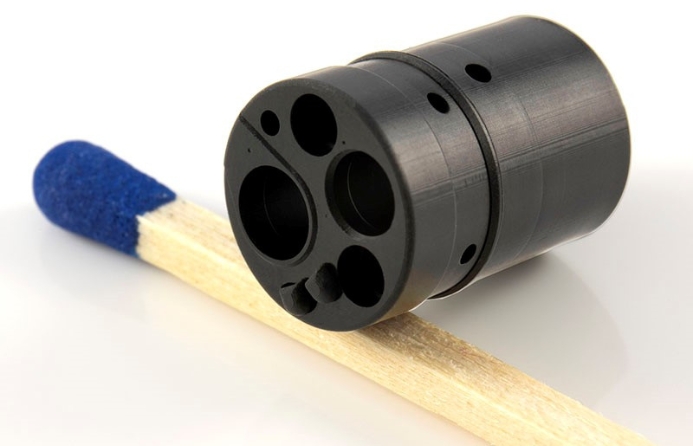

Bisher haben wir zum einen nur Daten mit den erwähnten Einschränkungen zur Verfügung, zum anderen war die Auswertung bisher nicht präzise genug. Beides ändert sich gerade, es entstehen kleinere Elektroden, die Mikroelektronik ermöglicht es, die Elektroden näher am Gehirn zu platzieren. Bei der Auswertung spielen die intelligenten Algorithmen eine immer größere Rolle. In Zeiten von Big Data können riesige Datenmengen in Echtzeit analysiert werden. Was bisher vor allem für Bildanalyse oder Spracherkennung genutzt wurde, wird nunmehr auch für die Untersuchung von Hirndaten eingesetzt. Das führt dazu, dass wir Hirnzustände immer genauer klassifizieren können und die Systeme immer besser werden, je länger sie die Daten der gleichen Person bekommen. Daher muss man sich Gedanken machen, was mit diesen Daten passiert und passieren darf.

Was genau gibt da Anlass zur Sorge?

Im Bereich Social Media und Internet hat uns die Entwicklung überholt. Wir haben uns daran gewöhnt, dass wir unseren Standort und sonstige Daten bereitwillig zur Verfügung stellen, um bestimmte Services zu nutzen. Auch wenn sich mittlerweile abzeichnet, wie viel man aus diesen Dingen ablesen kann und dass sie keineswegs geschützt sind, lässt sich die Entwicklung nicht zurückdrehen. Dabei ließen sich sogar Zusammenhänge zwischen bestimmten Social-Media-Aktivitäten und Depressionen oder sogar suizidalen Tendenzen nachweisen, wie Forschungsprojekte gezeigt haben. Und wie bedenkenlos wir Nutzungsbedingungen bisher zustimmen, zeigt ein scherzhaftes Experiment: Es war problemlos möglich, in Nutzungsbedingungen die Verpflichtung zu verstecken, beim Anbieter ein Jahr lang die Toilette zu reinigen. Soweit hatte aber offenbar kaum jemand gelesen, denn viele haben zugestimmt. Bei der Erfassung und Analyse von Hirndaten haben wir nun die Chance, sinnvolle Regeln festzulegen, bevor sich die Technik überall, auch im Consumerbereich, ausgebreitet hat. Diese Chance sollten wir nutzen.

Wie entwickelt sich die nicht-medizinische Nutzung solcher Hirndaten?

Große Konzerne wie Google oder Facebook sind an der Verwendung von Hirndaten zu unterschiedlichen Zwecken sehr interessiert und haben mit der Entwicklung entsprechender Geräte begonnen. Dabei kann es um Virtual Reality gehen oder um verbesserte Gaming-Erlebnisse. Vertreter dieser Unternehmen waren auch beim Workshop in den USA dabei und haben mit den Wissenschaftlern diskutiert. Bei Konzernen steht natürlich ein künftiges Geschäftsmodell hinter der Forschung. Regeln gibt es bisher nicht – genau genommen nicht einmal für die medizinische Nutzung der Daten, außer dass diese prinzipiell dem Wohl des Patienten zu dienen hat.

Inwiefern sind Hirndaten etwas Besonderes und schützenswert?

Sie sind die persönlichsten Daten, die man sich überhaupt vorstellen kann. Es ist zwar eine philosophische Frage, ob man damit Gedanken lesen kann. Es gibt Menschen, die das bejahen: Schließlich lassen sich damit Hirnzustände erkennen, die ja jedem Gedanken zugrunde liegen müssten. Aber auch wenn die Elektroden etwas auslesen, was wir nicht als „Gedanken“ formulieren könnten, lassen sich damit heute schon Roboter steuern und Gaming-Angebote anpassen. Meiner Ansicht nach sind aber Hirndaten weit mehr als biometrische Daten – ich sehe sie eher in Analogie zu Organen oder Geweben. Für diese gibt es Regeln, die verhindern sollen, dass sie gewerblich angeboten werden. In die Richtung sollten wir weiterdenken.

Wie schnell entwickelt sich die

Technologie?

Insgesamt geht es schneller voran als bisher vermutet, denn es wird viel investiert. Die Algorithmen werden Aufgaben mittelfristig besser erledigen können als Menschen. Dass eine Maschine beim Schach gewinnt, ist nur ein Beispiel dafür. Die lernende Software wird aber auch dazu führen, medizinische Entscheidungen zu unterstützen. Dass sie Bilder von Hautkrebs inzwischen schon genauso gut analysieren und zuordnen kann wie Hautärzte, wurde neulich in Science veröffentlicht.

Wie könnte ein Schutz der Daten im Alltag umgesetzt werden?

Als die aktuelle Veröffentlichung entstand, wurde beschlossen, im ersten Schritt nur die Handlungsfelder zu beschreiben. Weitere Artikel sollen folgen, in denen wir konkreter werden. Ein Schritt wäre meines Erachtens, die gemessenen Daten anders als bisher zu verwalten. Wenn sie einmal zentral in einer Cloud gespeichert sind und ausgewertet werden, ist ein unerlaubter Zugriff auf Daten und Ergebnisse nicht mehr auszuschließen – was unter Umständen auch eine rasche Personenzuordnung ermöglicht. Von Google-Vertretern kam beim Workshop der Vorschlag, die Rohdaten lokal zu speichern und, wenn das erforderlich ist, nur das Analyseergebnis weiterzugeben. Das wurde unter dem Stichwort Federated Learning diskutiert, und es erscheint mir als gangbarer Ansatz. Grundsätzlich muss aber zunächst die Frage geklärt werden, ob wir Hirndaten einen besonderen Status zuerkennen und sie so schützen wollen, wie wir es mit menschlichen Organen tun.

Wer trägt die Verantwortung für

einen möglichen Schutz?

Wo das Thema in der Medizin die Patienten betrifft, sind sie als eine verwundbare Gruppe in der Gesellschaft rechtlich besonders geschützt. Wenn ein Technik-Freak mit EEGs experimentiert und seine Daten preisgibt, gehe ich davon aus, dass er weiß, was er da tut. Die Verantwortung für die vielen möglichen Nutzer, die die technischen Hintergründe nicht so weit durchdringen können, müssen Politiker wahrnehmen und passende Rahmenbedingungen schaffen. Zum Beispiel dadurch, dass es klar strukturierte und für jeden verständliche Nutzungsbedingungen geben muss – in denen ein Konsument bestimmten Nutzungen explizit zustimmt und nicht erst ein gesondertes Opt-Out-Verfahren anstoßen muss, um der Verwendung seiner Daten zu widersprechen. Und auch Ingenieure sollten sich ihrer Verantwortung stärker bewusst sein. Für Mediziner, die ja mit Patienten zu tun haben, gibt es Pflichtveranstaltungen zur Ethik. So etwas sollte in Zeiten der Neurotechnik und der Biomedizinischen Technik auch für Ingenieure verpflichtend angeboten werden. Erste Bestrebungen in dieser Richtung gibt es auch schon.

Welches Risiko sehen Sie im Falle

eines nur geringen Schutzes?

Ohne Schutz werden Daten zugänglich, die vielleicht nicht mehr im Sinne der Individuen, sondern vor allem im Sinne von Geschäftsmodellen verwendet werden. Derzeit verlagert sich die neurotechnische Forschung bereits in kommerzielle Unternehmen oder in Labors, die militärischen Zwecken dienen. Das hängt auch damit zusammen, dass Wissenschaftler dort besser bezahlt werden. Die Konsequenz könnte sein, dass diese Einrichtungen sich damit eine gewisse Monopolstellung verschaffen und Erkenntnisse patentieren lassen, die außerhalb nicht mehr vorhanden sind und kaum noch bewertet werden können. Das halte ich für gefährlich. In den USA ist die Ko-Finanzierung durch militärische Mittel üblich, aber aus europäischem Blickwinkel finde ich das gewöhnungsbedürftig. Für kommende Workshops zum Thema ist allerdings geplant, mehr Vertreter aus Europa in die Diskussionen einzubeziehen.

Welchen Schutz wünschen Sie sich?

Ich begrüße es, dass derzeit eine Diskussion im Gange ist, ob man nicht als zusätzliches Menschenrecht die „Neurorechte“ definieren sollte. So etwas würde dann auch in eine Datenschutzrichtlinie gehören. Die neue europäische Datenschutzgrundverordnung geht da einen guten Weg und reicht schon recht weit, aber von Hirndaten ist noch nicht die Rede. Mich persönlich wüsste ich zu schützen, da ich mich beruflich intensiv mit dem Thema befasse. Aber was mich beschäftigt, ist die Lage der vielen Menschen, die das für sich nicht tun können und für die andere diese Aufgabe übernehmen müssen.

Was Hirndaten schützen soll

Gehirnaktivität könnte schon bald ähnlich einfach erfasst werden wie bislang Handydaten oder Bewegungsprofile. Aufgrund großer Investitionen kommt die künstliche Intelligenz weltweit schnell voran.

Neurowissenschaftler, Mediziner und Ethiker haben im Fachmagazin Nature im November 2017 vier Felder beschrieben, in denen sie besonderen Handlungsbedarf sehen – diese sind im Folgenden beschrieben. Weitere Publikationen sollen die Themen vertiefen.

- Datenschutz

Geräte, die die Hirnaktivität erfassen können, sollten die Daten nur nach ausdrücklicher Zustimmung der Nutzer teilen dürfen. Verkauf und Handel mit solchen Daten sollten, ähnlich wie bei menschlichen Organen, verboten sein.

- Verantwortung und Identität

Bei der gezielten Veränderung der Hirnaktivität kann sich die Eigenwahrnehmung einer Person ungewollt verändern und sogar die Grenze selbst- und fremdbestimmter Handlungen verschwimmen. Manipulationen der Hirnaktivität außerhalb medizinischer Therapien müssen verhindert werden. Darum sollte die Allgemeine Erklärung der Menschenrechte um den Schutz der Hirnaktivität erweitert werden.

- Selbstoptimierung/Militär

Auch Methoden zur Optimierung von Hirnfunktionen, etwa zum Verbessern des Gedächtnisses, werden weiterentwickelt. Dabei besteht das Risiko, dass medizinische Anwendungen für militärische Einsätze zweckentfremdet werden.

- Vorurteile durch Computer vermeiden

Erst die Auswertung der Hirnaktivität durch selbstlernende Computerprogramme, so genanntes Maschinelles Lernen, ermöglicht die massenhafte Auswertung der riesigen Datenmengen. Ist die Datengrundlage aber nicht neutral, fällt auch die Auswertung tendenziös aus. Wenn als Grundlage für ein Analyseverfahren beispielsweise nur Daten von Männern genutzt werden, werden Frauen möglicherweise benachteiligt.

Weitere Informationen:

Über die Aktivitäten der französischen nationalen Datenschutzbehörde CNIL, die sich auch mit ethischen Fragen bei Künstlicher Intelligenz befasst, berichtet Constanze Kurz in netzpolitik.org. Kurz ist promovierte Informatikerin und ehrenamtliche Sprecherin des Chaos Computerclubs.